XMLサイトマップ活用でクロール効率を向上させる方法 ~大規模ECサイトの運営視点から~

大規模なECサイトを運営していると、新商品ページの追加や価格変更、在庫状況の変動など、多数の更新が日常的に行われます。そのようなサイトでは、検索エンジンに対して「どのページを優先的にクロールしてほしいか」「どれが新しく更新された情報か」を適切に伝える仕組みが不可欠です。そこで活用すべきなのがXMLサイトマップです。本記事では、クロール効率を最大化するためのXMLサイトマップの作成・運用方法について、大規模ECサイトを念頭に置きながら詳しく解説します。

Contents

XMLサイトマップがもたらすクロール効率向上の意義

XMLサイトマップとは、サイト内の重要なURLを一覧化して検索エンジンに通知するためのファイルです。通常、検索エンジンのクローラーはサイト内のリンク構造をたどって新規ページや更新ページを発見します。しかし、大規模なECサイトでは以下のような理由でクローラーが巡回しきれないリスクが生じやすくなります。

- 商品数が膨大で、階層が深いページが多い

- カテゴリやフィルタ機能によるパラメータ付きURLが無数に生成される

- 新商品の追加や在庫切れ商品の削除など、更新頻度が高い

こうした状況下で重要なページや新しい情報がクローラーに見逃されると、インデックス速度が遅れ、結果として検索結果に表示されるタイミングも遅くなります。ECサイトでは新商品やキャンペーン情報をいち早く検索エンジンに認識させることが売上拡大の鍵になるため、クロール効率をいかに高めるかが極めて重要です。

XMLサイトマップを活用することで、どのURLを優先的に見に来てほしいかを検索エンジンに明示でき、新商品ページや更新ページを確実かつ迅速にクロールしてもらいやすくなります。クロールバジェット(検索エンジンがサイトに割り当てるクロールの回数・リソース)を無駄に消費せず、必要なページのみに集中してもらうことで、大規模サイトの運営上の問題を解消しやすくなるのです。

XMLサイトマップと検索エンジンの連携ポイント

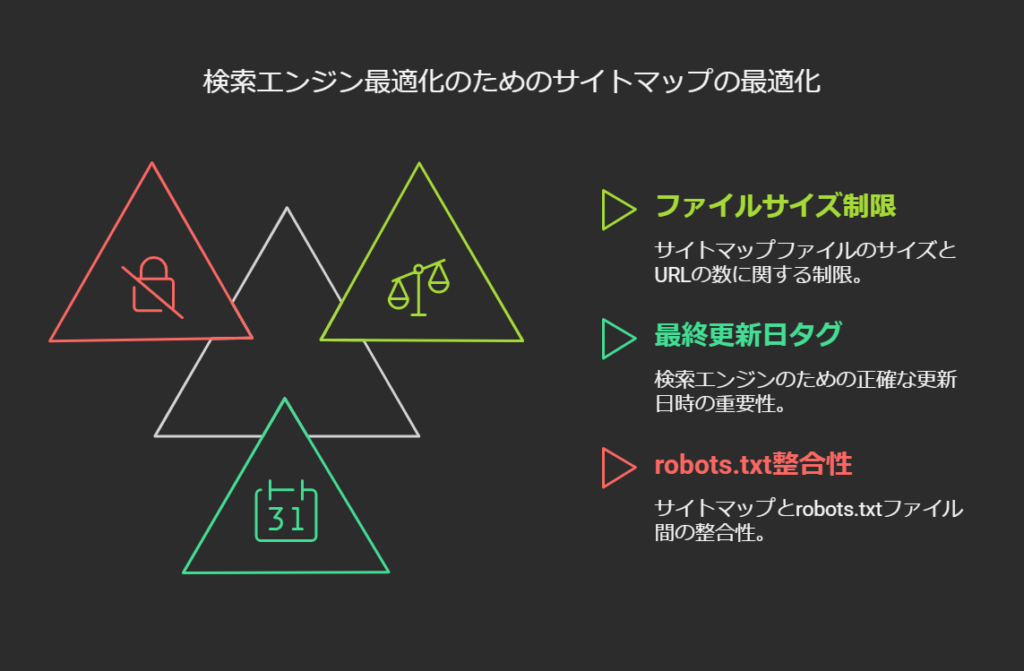

検索エンジン(特にGoogleやBing)は、サイトマップの送信を正式に推奨しています。彼らのガイドラインで主に挙げられるポイントは次のとおりです。

- ファイルサイズとURL数の上限

1つのXMLサイトマップファイルにつき「最大50MB」「最大5万URL」という上限があります。大規模ECサイトの場合は、この上限を超える可能性が非常に高いため、分割して複数のサイトマップを作り、さらにそれらを束ねる「サイトマップインデックスファイル」を用意する必要が出てきます。 - lastmod(最終更新日)の活用

<lastmod>タグにページが更新された正確な日時を記載すると、検索エンジンはその変更を効率的に把握できるようになります。ただし、更新していないページのlastmodを頻繁に書き換えるのは逆効果です。検索エンジンが「このサイトマップは不正確だ」と判断すると、サイトマップ情報自体の信頼性が落ちてしまうため、実際にコンテンツが更新されたときだけ正確な日時を記載しましょう。 - robots.txtやnoindexとの整合性

サイトマップに載せるURLは基本的に「検索エンジンにインデックスしてほしいページ」に限定します。もしもあるページをnoindexにしているなら、そのURLはサイトマップに含めない方が望ましいです。また、robots.txtでブロックされているページをサイトマップに含めると矛盾が生まれ、クローラーはそのURLを「見えているのにクロールできない」と認識してしまいます。

大規模ECサイト向けの分割・更新頻度設計

サイトマップ分割のメリット

ECサイトでは商品ページが数十万、あるいは数百万に及ぶケースも少なくありません。その場合、単一ファイルに5万URLまでという上限に抵触するだけでなく、たとえ上限以下でも管理しきれなくなる恐れがあります。そこでサイトマップを複数ファイルに分割して運用する方法が効果的です。

- カテゴリやブランドごとにサイトマップを分割

「家電」「ファッション」「食品」など大項目に応じてファイルを分けておくと、どのカテゴリーでインデックス漏れが発生しているかをSearch Consoleで確認しやすくなります。また、カテゴリーごとに在庫変動の頻度が異なる場合、更新の必要なサイトマップだけを重点的に再送信することができます。 - 更新が頻繁なページと静的ページを分割

商品ページは価格変更やセール情報の追加など、変更が多い一方、会社概要や利用規約などはほとんど変わりません。そこで、更新頻度が高いページのサイトマップと静的ページ用サイトマップを分けておくと、クローラーは効率的に「変化が多いサイトマップ」を中心にチェックできるようになります。

更新頻度と自動化

ECサイトでは新商品の追加、既存商品の廃番や在庫切れなどが日常茶飯事です。サイトマップは更新が発生したタイミングで即時に再生成し、検索エンジンに通知することが理想的です。しかし、すべてを手動で行うと人的リソースやミスのリスクが大きくなります。そこで次のような手段を用いることが多いです。

- CMSやフレームワークのプラグインを利用

たとえばWordPress(WooCommerce)ならYoast SEOと連携して自動的にサイトマップを生成・分割してくれます。商品が追加・削除されるたびにサイトマップを自動更新し、Search Consoleにも送信可能です。 - バッチ処理やスクリプトで定期生成

独自CMSの場合でも、商品マスタの更新が行われるタイミングでバッチ処理を走らせてサイトマップを出力する仕組みを導入すれば、人的オペレーションを最小化できます。Google Cloud FunctionsやAWS Lambdaを使うことでスケジュール実行し、S3やCloud Storageへ定期的にアップロードする方法もあります。 - Screaming Frogやその他クローラーツールによる定期自動クローリング

サイト全体をクローリングしてリンクからURLを拾い、それをXMLサイトマップとしてエクスポートする手法もあります。ただし、クローラーベースの生成では社内限定ページや認証が必要なURLを取得できないなどの注意点があるため、URL重複や要らないパラメータの除外設定が不可欠です。

Search Consoleとの連携とエラー対策

Search Console上でサイトマップを送信すると、どのURLがインデックスされ、どれがエラーや除外になったかを可視化できます。エラーや除外の理由を確認し、適切に対処することで、クロールとインデックスの効率をさらに高められます。

- 送信したURL数とインデックス数の差

差が大きい場合、重複コンテンツや品質の低いページが多い、あるいはnoindexやrobots.txtでブロックされているURLが混在しているといった可能性が考えられます。また、サーバーエラーやページが見つからない(404など)が多数含まれる場合もインデックスされにくくなるでしょう。 - 除外ステータス「重複 (Google により選択された正規ページではありません)」

これはいわゆる「重複ページだけど、検索エンジンが別のページを正規として扱った」状態を示します。パラメータ付きURLや類似ページが多いECサイトではよく見られます。重複ページを頻繁にサイトマップに載せるとクローラビリティにマイナスが生じるため、canonical設定などで正規URLを明確にし、サイトマップにはその正規URLのみを掲載する方が賢明です。 - 404エラーや410エラー

廃番商品ページなどを削除した場合、既にインデックスされているURLを放置するとクローラーが何度も無駄に巡回してしまうため、Search Consoleで早めにインデックス除去を確認し、サイトマップからも削除しましょう。もし再入荷予定が全くない商品であれば、HTTPステータス410で「永久に存在しない」ことを示すと、より早くインデックスが削除されます。 - 「クロールが拒否されました」などのメッセージ

robots.txtでブロックされていたり、サイトマップがBasic認証エリアに置かれている場合に発生します。この状態では検索エンジンがサイトマップの中身を確認できず意味を成さないので、一般公開されているフォルダにサイトマップを置き、robots.txtでもブロックしないように設定しましょう。

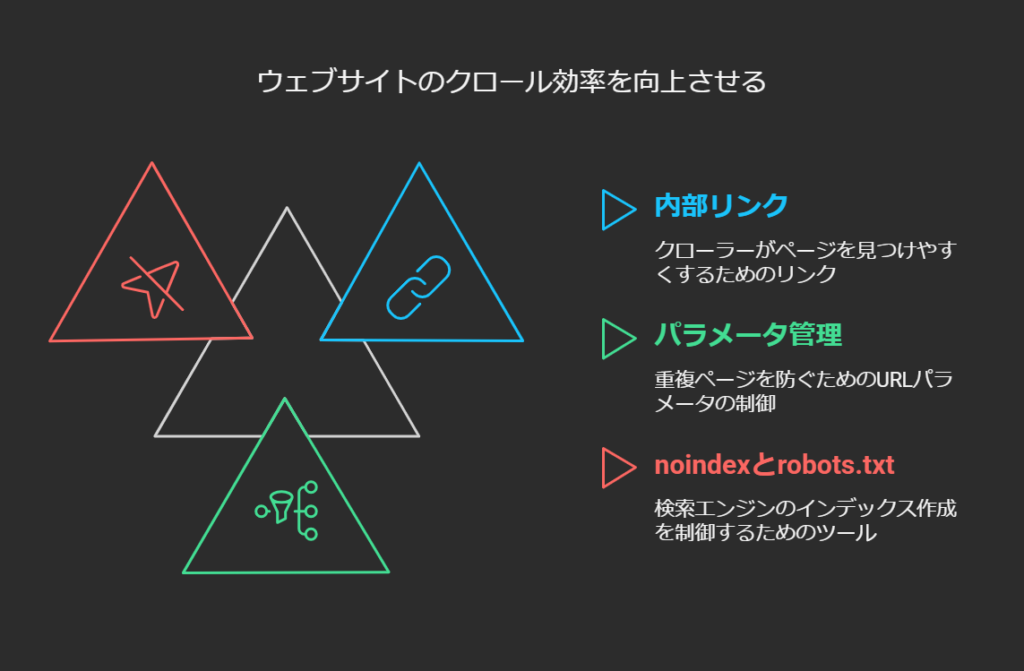

内部リンク構造と併用したクローラビリティ向上

XMLサイトマップはあくまでも「重要なURL一覧を提示する」手段であり、リンク構造によるクローラビリティをすべてカバーできるわけではありません。サイト内リンクは、クローラーがサイトマップで見つけたURLを巡回する際に参照される大事な要素です。以下の点を意識してサイト全体のクローラビリティを底上げしましょう。

- 主要商品ページやカテゴリページへの内部リンクを適切に配置

トップページやカテゴリトップなどから数クリックで辿れる階層構造を意識することで、クローラーに対してもユーザーに対しても巡回しやすい設計を提供します。 - 無数のパラメータ付きURLを作らない設計

フィルタやソート機能によるパラメータはユーザーにとって有益ですが、クローラーには膨大な重複ページをもたらす可能性があります。canonicalタグや適切なリンク構造で検索エンジンに「これが正規版ページだ」と示すのが大切です。サイトマップには必ず正規版URLのみを掲載します。 - noindexやrobots.txtを組み合わせた制御

明らかに重複度が高く、検索結果に表示したくないURLは、最初からnoindexやrobots.txtでブロックしつつ、サイトマップには含めないようにします。クローラーの無駄足を防ぐことで、より重要な商品ページにクロールリソースが割かれるのです。

在庫切れ・廃番商品の扱いとサイトマップ運用

ECサイトならではの大きな課題として「在庫切れ商品や廃番商品をどう処理するか」が挙げられます。これらのページをどう扱うかによって、クロール効率やサイト全体のユーザー体験が左右されます。

- 在庫切れだが再入荷の見込みがある商品

完全に削除するのではなく「在庫切れ中」のステータスを表示し、商品が復活したときに同じURLで再度有効にする方法があります。このページをサイトマップに含めておくと、クローラーも「存在し続けるページ」と認識し、再入荷後の更新も素早く反映される可能性が高いです。クローラーがページを見た時には在庫切れ表示になっていても、コンテンツ自体は価値を保つ場合があります。 - 完全に廃番になり、今後復活予定がない商品

404か410ステータスを返し、サイトマップからも削除します。購入できない商品ページをいつまでもサイト上やサイトマップに残すと、クローラーが無駄に巡回してしまい、ほかの新商品ページの発見が遅れる一因となりかねません。ユーザーがブックマークしている可能性などを考慮し、関連商品へリダイレクトする方法も検討できますが、リダイレクト先が検索エンジンにとって不自然なケース(まったく関係のない商品など)は避けた方がよいでしょう。 - 廃番商品の大量処分時のサイトマップの活用

何千、何万という商品を一斉削除する場合、専用の「削除対象URLサイトマップ」を一時的に作って、Search Consoleで送信するというやり方もあります。これにより、Googleに削除対象の存在を明示し、インデックスを速やかに削除させる狙いがあるのです。こういった方法はサイトリニューアルや商品入れ替えが大きく行われる際に役立ちます。

よくあるエラーやクローラー混乱を招くケース

重複ページの氾濫

ECサイトの同じ商品が色違いやサイズ違いなどで別URLになるケースは多々あります。これ自体はユーザーにとって有益な場合もありますが、クローラーにとっては「似たようなコンテンツが大量に存在する」状態となり、インデックス効率を下げる原因になりかねません。サイトマップには原則、検索結果に表示したい「正規のURL」のみを登録し、ほかはrel="canonical"で誘導するのが鉄則です。

パラメータ付きURLの制御ミス

「ソート順」「カラー」「サイズ」などをURLパラメータで切り替える設計にすると、商品×パラメータの数だけURLが生成される可能性があります。必要に応じてnoindexやcanonicalを活用し、サイトマップには重要なページだけを掲載しましょう。重要度の低いパラメータ付きページをサイトマップに入れてしまうと、クローラーはそこに時間をかけてしまい、本当に優先すべきページが後回しになる恐れがあります。

lastmodの使い方が不適切

前述のとおり、コンテンツ更新時には<lastmod>タグを正確に更新することが大切です。逆に実際には変更のないページにもかかわらず日付を自動で上書きしてしまうと、信頼性が損なわれ「本当に更新があったのかどうか」を検索エンジンが疑う結果となります。これが頻発するとサイトマップ全体が信用されにくくなり、新商品を追加してもすぐにはクロールが回ってこない状況に陥る可能性があるのです。

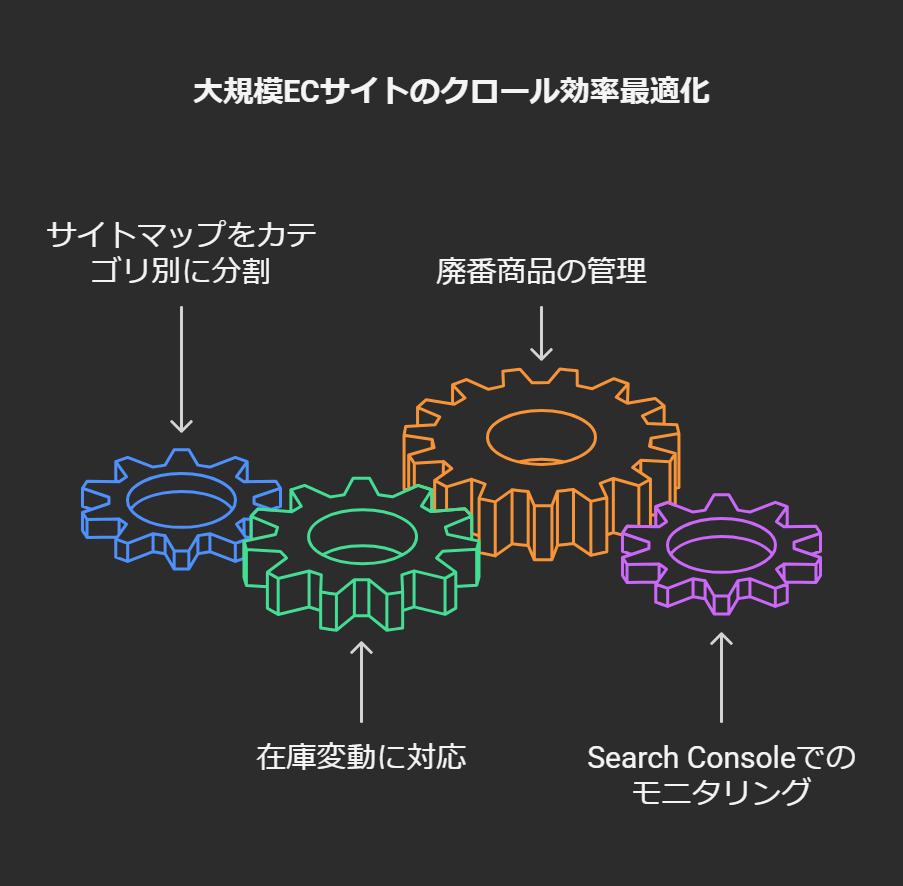

成功事例:サイトマップ分割と運用ルールの徹底

ここで、複数のサイトマップを活用してクロール効率を改善した大規模ECサイトの運用例を紹介します。

- 商品ページをカテゴリ別に分割

まず「レディースファッション」「メンズファッション」「キッズ」「アウトレット」など、カテゴリ大項目ごとにサイトマップを分けました。1ファイルあたり最大5万URLという制限を考慮しつつ、さらに細分化したカテゴリ別に複数ファイルを作成し、それらをまとめるサイトマップインデックスをSearch Consoleに送信しました。 - 在庫状況の頻繁な変化に対応

商品の在庫ステータスが変わった場合には「更新があった商品サイトマップ」を自動生成し、そのサイトマップだけを再送信するようバッチ処理を組みました。これにより、サイト全体のURL数が膨大であっても、更新のないカテゴリのサイトマップは触らず、更新のあるカテゴリだけを再送信できます。lastmodは実際の在庫ステータス変更があったページのみ正確に更新するようにし、検索エンジンに無駄な混乱を与えないよう気を配りました。 - 廃番商品の扱い

完全に販売終了となった商品は、できるだけ早めにサイトマップから削除し、在庫切れが一時的なものならページを残すポリシーを導入しました。廃番商品はステータス410を返してクローラーに「もう存在しないページ」と明示しつつ、サーバーログを監視して「クローラーがそのURLをリクエストした回数」を確認し、訪問が激減したタイミングで関連する内部リンクを整理。結果、クローラーバジェットが再入荷商品や新商品のページへ振り向けられ、インデックスが速まったという報告があります。 - Search Consoleでの定期モニタリング

カテゴリ別サイトマップのインデックス率を継続的にチェックし、インデックス率の低いカテゴリやエラーが多発しているカテゴリを重点的に調査。たとえば「メンズファッション」が他と比較してインデックスされにくい場合、内部リンク設計やページの品質面で問題がないかを深堀りすることで、検索結果での露出改善に結びつけています。

このように、分割運用と更新ルールの厳守を徹底することで、検索エンジンへの通知が適時かつ正確に行われ、サイト全体のクロール効率を高められます。大規模ECサイトほど、このような細かい運用ルールづくりと自動化が欠かせません。

ツールを活用したスムーズなサイトマップ生成

ECサイトが扱う商品数が非常に多い場合、サイトマップの生成や更新をすべて手動で管理するのは非現実的です。以下のツール・手段を活用し、自動化・半自動化を図るのが一般的です。

- Yoast SEO

WordPress + WooCommerceのような構成でECサイトを運用する場合には、Yoast SEOのXMLサイトマップ機能を用いると手軽です。商品追加や更新のたびに自動生成され、Search Consoleへの送信もスムーズに行えます。重複ページやnoindexページはデフォルトでサイトマップに含めない設計になっている点もありがたいところです。 - Screaming Frog SEO Spider

サイトをクローリングしながらXMLサイトマップを出力できます。巨大サイトでは有料版が必要となりますが、robots.txtでブロックされていないURLを幅広く検知し、不要なパラメータURLを除外するフィルタ設定などが可能です。スケジュール機能と連携すれば「週に一度サーバーをクロールしてサイトマップを自動更新する」という運用も実現可能です。 - クラウドファンクション(Google Cloud Functions / AWS Lambda)

独自CMS+大規模データベースのECサイトであれば、在庫や価格情報の更新時にトリガーを設定し、Cloud FunctionsなどでXMLサイトマップを生成・アップロードする方法があります。バッチ処理のコストが低く、サーバーリソースを節約できる利点があります。商品マスタから直接URLリストを抽出できるなら、スクリプトで整形してサイトマップXMLを作るアプローチが最も無駄がありません。 - Google Search Console API連携

Search ConsoleにもAPIがあるため、サイトマップの送信やインデックス状況の取得をプログラム上で自動化できます。これを使えば、サイトマップを更新したタイミングで即座に「サイトマップを再送信し、結果をチェックする」というワークフローが可能になります。

今後のトレンドと継続的改善の重要性

検索エンジンは日々アルゴリズムやクロール方式をアップデートしており、「クロール予算の削減」を目標とする動きが進んでいます。これは、環境負荷やサーバー負荷の観点から、必要のないページのクロールを減らそうとする流れです。ECサイト運営者としても、以下の点を引き続き注視しながら運用の最適化を図りましょう。

- lastmodのより厳格な評価

近年、Googleがサイトマップの<lastmod>が正確に管理されているかどうかを厳密にチェックすると明言しており、信用されない場合は「サイトマップの更新情報をすべて無視される」可能性もあるとされています。これは大規模ECサイトでは特に重要な問題であり、誤った運用でlastmodを上書きし続けると信用を損なうかもしれません。 - IndexNowなどの新通知プロトコル

BingやYandexはIndexNowという仕組みを導入し、ページ更新時に即通知を受け取りインデックスのタイムラグを減らす動きがあります。現時点ではGoogleが対応していないため、国内ECサイトではそこまで効果を見込めない場合もありますが、もしGoogleが今後参加するとなればサイトマップと合わせて検討していくとよいでしょう。 - モバイルファーストやページエクスペリエンス指標との関連

XMLサイトマップ自体はモバイル向けページを別途指定するための仕組みや、ページエクスペリエンス指標との直接的な関係はありません。しかし、ページ速度が遅いサイトはクローラーの巡回も効率が落ちるため、総合的なサイト品質向上が結果としてクロール効率にもプラスに働きます。たとえば大量の不必要なJavaScriptでレスポンスが遅くなっていると、クローラーがクロールを途中で切り上げる可能性があります。そのため、サイトマップだけでなくサイト全体のスピードやモバイル対応、内部リンクの整備を並行して行いましょう。 - 構造化データとの相乗効果

商品ページに構造化データ(Product情報など)をきちんと埋め込むと、検索結果のリッチリザルトとして表示される可能性が高まり、結果的にクリック率が上がります。クリック率が上がると、そのURLがクロールされる頻度も増えやすい傾向があるため、「サイトマップでURLを通知し、構造化データによってページの有用性をアピールする」という二段構えの戦略も検討すべきです。

まとめ:運用ルールと自動化の仕組みづくりが決め手

大規模ECサイトにおいてXMLサイトマップの活用は、クロール効率を高め、インデックス促進を加速するための強力な武器となります。以下のポイントを押さえて自社サイトの運用に反映してみてください。

- サイトマップの分割

URL数やカテゴリ構成に応じて複数のXMLファイルに分割し、サイトマップインデックスを用いて整理する。更新頻度の高いカテゴリと低いカテゴリを分割することで、クロールリソースを有効に使える。 - lastmodの正確な管理

変更があったページだけ正しい更新日時を記載し、変更のないページの日時は書き換えない。正確性を保たないとサイトマップ全体の信用を損ねる。 - 不要URLの排除

noindexや重複ページ、廃番商品ページはサイトマップに含めない。これによりクローラーが巡回すべきURLを明確化し、クロールバジェットを有効活用できる。 - 自動化と継続的な監視

CMSプラグインや自動生成スクリプト、クラウドサービスを活用し、人的な更新作業を減らす。Search Consoleやログを定期的にチェックし、エラーや除外が増えた場合はすぐに原因を究明して修正する。 - 内部リンク構造との相乗効果

サイトマップはあくまでもURL一覧の補完的役割。内部リンク構造を整え、クローラーが自然にサイトを巡回できる環境を整えることで、結果的にクロール効率を最大化する。

ECサイト運営においては、商品数の多さや更新頻度の高さが「インデックスに間に合わない」「重複ページが氾濫する」など様々な問題を引き起こしますが、XMLサイトマップを含めたテクニカルSEOの対策をしっかり施すことで、そのリスクを大きく軽減できます。さらに、Search Consoleを活用してエラーやカバレッジレポートを分析しながら運用ルールを定期的に見直していけば、新商品リリースのたびにスムーズなインデックスを実現し、SEO面でも販売機会のロスを最小限に抑えられるようになるでしょう。

大規模サイトほど、運用ルールの確立と自動化の仕組みづくりが成功のカギです。更新漏れや不正確なサイトマップの送信を続けていると、Googleなど検索エンジンからの信頼を損ない、せっかく追加した新商品ページの表示が遅れて売上機会を逃す恐れもあります。一方で、サイトマップを「生きた目録」として常に手入れをし、商品の追加・削除をスムーズに反映する運用体制を構築できれば、検索エンジンとの良好なコミュニケーションを維持し、より多くの新規ユーザーを効率的に獲得する道が拓けるのです。