URLパラメータ管理とクローラビリティ最適化

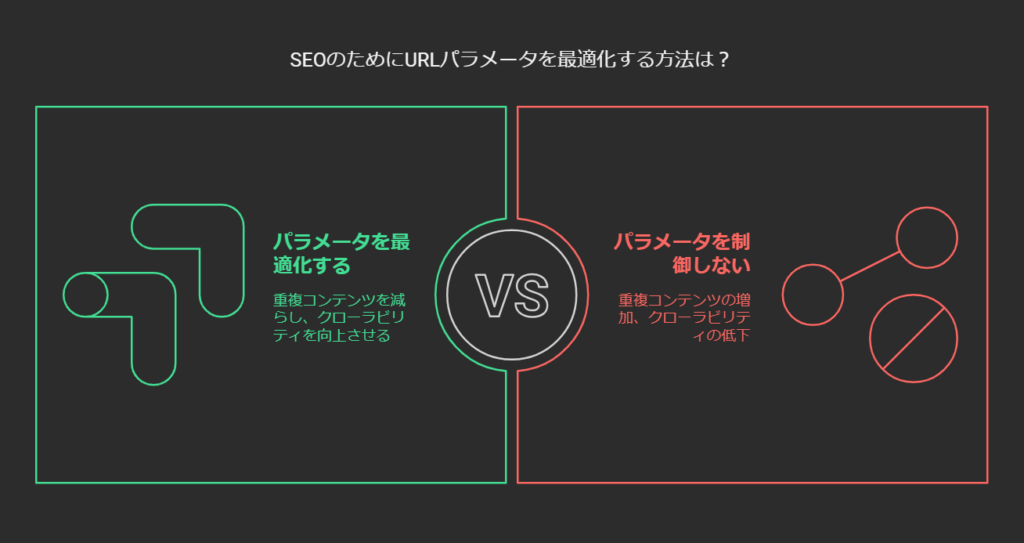

クローラーがサイトを巡回し、ページを正しくインデックスするためには「URLパラメータ」の扱いが非常に重要です。特にECサイトでは、商品検索やフィルター機能、トラッキングコードなどで多数のパラメータ付きURLが生成されがちです。これらのURLが適切に制御されていないと、重複コンテンツやクローラーのリソース浪費が生じ、結果としてSEO評価の低下やインデックスの遅延を招く恐れがあります。

本コラムでは、ECサイトを運営する視点も踏まえながら、URLパラメータの乱立による問題点と影響、パラメータの整理・管理方法、Search Console(旧・URLパラメータ ツールを含む)での設定、noindex・canonicalタグなどを使ったクローラビリティ改善策、さらに具体例や最新のGoogleアルゴリズムの傾向について総合的に解説します。ECサイトに限らず、大規模メディアやサービスサイトの運営にも有用な知見を盛り込んでいますので、ぜひ参考にしてください。

Contents

URLパラメータが生み出す問題とSEO上の影響

ECサイトや各種Webサービスでは、ユーザーの利便性向上や広告計測、トラッキングのために多種多様なパラメータを付与することがあります。例えば、色・サイズ・価格帯などの商品検索フィルタ、並び替え順を指定するソートパラメータ、Google Analytics用のUTMパラメータ、独自のリファラパラメータなどが代表的です。これらのURLパラメータは便利な反面、うまく制御しないと以下のような問題を引き起こします。

重複コンテンツが大量発生する

同一または非常に類似したコンテンツにもかかわらず、パラメータだけが異なるURLが増えると、検索エンジンはどのURLを正規のページとして扱えばよいか分からなくなります。結果的にページ評価が分散し、検索順位を押し上げる力が弱まることも少なくありません。ECサイトでは「カラー別」「サイズ別」で実質同じ商品一覧を返すケースが典型例で、これが何十・何百と組み合わせられると、サイト内に膨大な重複ページが生まれてしまいます。

クローラビリティ低下・インデックス遅延

Googleなどの検索エンジンは「クロールバジェット」と呼ばれる巡回リソースの上限内でサイトをクロールします。パラメータの乱立によって似たようなページが増えすぎると、クローラーが重要ページを巡回する前に無駄なURLに時間を取られ、更新情報の発見や新商品のインデックスが遅れる恐れがあります。特にECサイトでは新商品やセール情報の更新が頻繁なため、クローラーの巡回が滞ると売上にも直結しかねません。

外部評価(被リンク・シェア)の分散

重複URLが乱立する状況では、ユーザーや他サイトからの被リンクが複数のURLにバラバラに集まります。結果として、どれか1つのURLに評価が集中せず、SEO上の効果が薄まりがちです。検索結果でも複数の重複ページが出現してしまい、クリック率(CTR)の低下などマイナス要因も増えていきます。

クリック率やユーザー体験の影響

パラメータがやたらに長いURLは、検索結果ページ上で視覚的に煩雑になりやすく、ユーザーが敬遠する場合もあります。特にECサイトにおいては、本来ならシンプルで分かりやすいURLが望ましいのに、長ったらしいパラメータ付きURLが並ぶとブランドイメージにも影響しかねません。CTRの微妙な低下要因としても考えられます。

パラメータ管理の基本方針:まずは「乱立を防ぐ」こと

パラメータの分類・整理

効果的なパラメータ管理には、まずサイト内で使われているパラメータをすべて洗い出し、その役割を分類することが重要です。大まかに分類すると、以下のようなパターンがあります。

- 表示内容に影響するパラメータ: 絞り込み、並び替え、ページングなど

- 表示内容には影響しないが計測目的で使うパラメータ: UTMソース、リファラ識別子、セッションIDなど

- その他特殊なパラメータ: 言語切り替え、在庫状況表示、会員ランクなど

「表示内容に影響するパラメータ」のうち検索エンジンに評価されたいページ(例:カラー別の商品ページ)とそうでないページ(例:マイナーなフィルタを組み合わせただけで本質的に新情報のないページ)を分け、後者はnoindexや非公開設計(AJAXなど)で対応する、といった線引きが重要です。

URLパラメータの順序を統一・正規化

同じパラメータでも「順序」が異なるだけで、検索エンジンは別URLとして扱います。例えば?color=red&size=mと?size=m&color=redは機能的には同じページを表示しても、クローラーは2つのURLを別物とみなしクロールする可能性が高いです。したがってパラメータの順序はサーバー側で統一し、ユーザーがどの順番で操作しても一定の並びになるようリダイレクトする仕組みが望ましいでしょう。

不要なパラメータの排除

古い計測タグや使わなくなったパラメータが放置されていると、開発者も存在を忘れていることがあります。こうした不要パラメータはスクリプトや設定ファイルで無視してしまう、あるいはクッキーやセッション管理など別の方法に置き換えてURLに含めないようにすることで、サイト全体のURLバリエーションが減り、重複ページが格段に少なくなります。

静的URLへの置き換えも検討

ECサイトで特定カテゴリや言語設定などがSEO上も重要な場合は、パラメータよりディレクトリやパスとして表現する方法が有力です。例として、?category=shoes&gender=womenよりも、/women/shoes/のようにパスで表したほうが検索エンジンにも分かりやすく、ユーザーにもURLの内容が直感的に伝わります。ただし、価格帯や無数のフィルタ条件をすべて静的URLにすると逆にURLが増えすぎてしまう危険もあるため、取捨選択が必要です。

Search Consoleでのパラメータ設定:旧URLパラメータ ツールとその廃止

かつてはSearch Consoleに「URLパラメータツール」という機能があり、サイト管理者が「このパラメータはページ内容に影響しないのでクロールしないでほしい」「このパラメータは絞り込みなので一部だけクロールしてほしい」といった指示を与えることが可能でした。しかし、2022年4月にこのツールは廃止され、Googleは「パラメータを自動的に認識・処理できるようになった」とアナウンスしています。

ツール廃止後の現状

URLパラメータツールが廃止された結果、管理者が明示的にクロール挙動を制御する手段は減りました。ただし、Googleは内部アルゴリズムによって「重複度の高いパラメータ付きURL」は自動的に評価を統合し、不要なURLはインデックスしないよう進化を続けているとされています。実際、ECサイトでもパラメータ付きのソートページやトラッキング用URLが自然と検索結果に出なくなるケースが増えています。

誤設定リスクが減るメリットも

URLパラメータツールは便利な反面、設定を誤って主要コンテンツまでクロールさせないようにしてしまう事例が後を絶ちませんでした。ツール廃止により、こうした誤設定による「インデックスされるはずのページが消えてしまう」事故が起きにくくなった点はプラスと言えます。とはいえ、大規模ECなど「どうしても手動設定したい」ケースで不便を感じることもあるため、代替策としてnoindexやrobots.txt、メタタグなどでの制御がますます重要になりました。

現在の推奨方針

- 「自動処理」に任せられる部分は任せる

Googlebotがうまく重複ページを識別してくれる可能性が高いため、あまり細かな指示が不要になりつつあります。 - 必要であればnoindex, canonical, robots.txtなど標準手段を活用

検索エンジンに誤解を与えない明確な方法で、パラメータ付きURLを除外したり統合したりします。 - 既にインデックスされている不要ページには要注意

robots.txtでブロックしてしまうとクローラーがnoindexタグを読めなくなり、インデックスから完全に外せないケースもあるため、段階的にnoindex -> インデックス削除確認 -> 最終的にブロックといったプロセスが望ましいです。

noindexやcanonicalタグの使い分け

noindexタグで明示的に除外

<meta name="robots" content="noindex, nofollow">と指定すると、Googleはそのページをインデックス対象から外します(既にインデックスされている場合は、次のクローリング後に削除手続きへ)。ECサイトで典型的な利用例は「検索結果ページ」「在庫切れページ」「ログイン専用ページ」などです。いずれもサイトとしては検索エンジンに表示させたいページではありませんから、noindexでクローラビリティを抑制し、かつ検索結果への不要な表示を防ぎます。

ただし、noindexにするページの内部リンクは、長期的には検索エンジンから評価されない傾向があります。もしそのページをナビゲーションハブとして利用しているなら要注意です。理想としては、ユーザーだけが使うフォームやJavaScriptでの切り替えを導入し、URL自体を生成しない構造にするのが最善策の場合も多いでしょう。

canonicalタグで重複ページを正規化

<link rel="canonical" href="正規URL" />を追加することで、「このページと正規URLの内容は同一であり、インデックスや評価は正規URLに集約してほしい」と検索エンジンに伝えられます。ECサイトの例として、「/products?color=redは/productsと同じ商品一覧だ」というケースでcanonicalを設定すれば、Googleは基本的に/productsをメインのURLとして扱い、color=redのほうは重複ページとしてインデックスから外そうとします。

canonicalは強制力ではなく「推奨」指示ですが、Googleは通常この指示を尊重するため、重複ページを統合したい場合に非常に有効です。ただし、パラメータページが実際にかなり異なる内容(例えば在庫やオススメ商品の順序が大幅に違う等)の場合、canonicalを無視されるケースもあります。あくまで「重複または非常に近い内容」かつ「ユーザーにとっては同じページ」とみなせる場合に活用すると良いでしょう。

robots.txtとの違いと使い分け

robots.txtは、特定のURLパターンをクローラーが巡回しないように指示する仕組みで、アクセス前にブロックするためサーバー負荷やクローリング時間を節約できます。しかし、一度インデックスされてしまったページに対してはrobots.txtだけではインデックスから除外できません。というのも、クローラーがページをブロックされると中身を確認できず、noindexタグを読み取れないからです。

そのため、すでに検索結果に載ってしまったパラメータページを「検索結果から消し去りたい」場合、まずnoindexを付与してクローラーに内容を読ませることが必要になります。インデックスから外れたのを確認してから、最終的にrobots.txtでブロックする方法が一般的です。一方、「最初から無数に生成される検索結果ページを全てクロールさせたくない」という状況では、早い段階でrobots.txtを用いる方がサーバー負荷削減には有効です。

ECサイト運営におけるクローラビリティ最適化のポイント

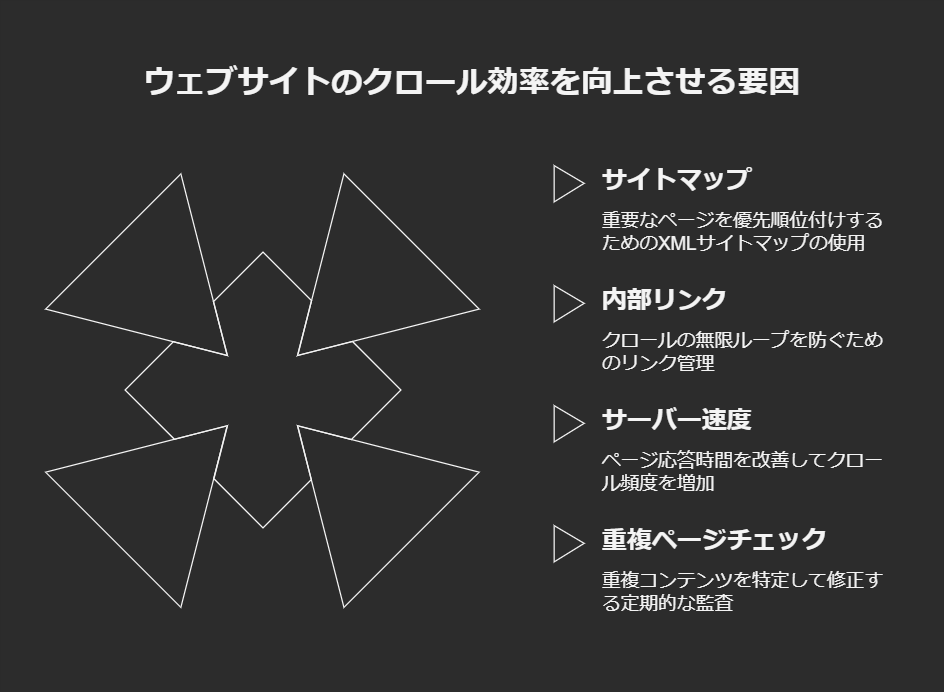

サイトマップの活用

ECサイトで商品点数が膨大な場合、XMLサイトマップを使って「本当にインデックスしてほしい」商品ページやカテゴリページを明示することができます。Googleはサイトマップを参考にクロールの優先度を調整するため、パラメータ付きの派生URLよりもまずはサイトマップ掲載URLを重点的に巡回してくれます。更新が頻繁なECサイトほど、商品追加や在庫更新のタイミングでサイトマップを更新・再送信するとインデックスを効率的に促せます。

内部リンク構造の整理

全ての絞り込み条件をHTMLリンクで羅列していると、クローラーが無限に近いリンクを辿ってしまいます。例えば色・サイズ・価格・ブランドなどが掛け合わされると、何百何千というリンクが生成されかねません。対処として、あまりに細かな絞り込みリンクはrel="nofollow"を付ける、もしくはJavaScript/AJAXで生成して検索エンジンにリンクとして認識されないようにする方法があります。もちろんユーザー体験とSEOのバランスを見極める必要がありますが、重大な無限ループを防ぐには有用です。

サーバー速度・エラー管理

クロールバジェットはサイト速度にも影響されます。ページが高速に応答すればGooglebotは「このサイトはスムーズにクロールできる」と判断し、1日のクロール数を増やす傾向があります。逆に大量のエラー(404など)があると「エラーが多いサイト」とみなされ、クロール頻度を下げられるケースもあります。ECサイトでは売り切れ商品ページの管理や廃止商品ページのステータスを正しく設定し、不要になったページは410(Gone)などを返すなどして、エラーページがダラダラと生き残らないようにするとよいでしょう。

定期的な重複ページチェック

ECサイトではシーズンごとに商品ラインナップが入れ替わることが多く、新しいパラメータや季節用フィルタが追加される可能性があります。開発チームが新機能を導入した際、それに付随するパラメータが正しく制御されているかは常に確認が必要です。Screaming Frogや他のSEOクローラーでサイト全体をスキャンし、「同じタイトルや同じH1を持つURLが大量にないか」「似たようなコンテンツが複数URLに分散していないか」を定期的に監査することをおすすめします。

具体的な事例:大規模ECサイトの成功・失敗例

成功例:YesStyleのファセットナビゲーション整理

海外の大規模ファッションECサイト「YesStyle」では、ファセット検索(色、サイズ、ブランドなどの複合フィルタ)が非常に豊富で、理論上は膨大なパラメータ付きURLが生成されていました。当初はそれらを全てインデックス対象にしていたため、重複コンテンツとクローラービリティ低下に苦しんでいたといわれます。そこで、同社は以下の施策を実施しました。

- 主要カテゴリー数を絞り込み、不要なカテゴリを統合・廃止

- 細かなフィルターは基本AJAXで絞り込みを実行し、URLを生成しない

- どうしてもURLが生成される絞り込みにはcanonicalタグで親カテゴリに集約

この結果、重複ページが大幅に減少し、Googleが優先的にクロールすべき商品ページへリソースが割かれるようになりました。オーガニックトラフィックは数カ月で大幅に増加し、検索結果の露出と売上が向上した成功例として知られています。

失敗例:旅行予約サイトのフィルタ乱立

一方、ある旅行予約サイトでは「出発地 × 目的地 × 日付 × 日数 × 価格帯」など複合的に検索できるUIをそのままURLパラメータ化して提供していました。数え切れないほどの組み合わせページが生成され、Googlebotがサイト内を延々とクロールする状態が続いていました。サイト管理者はこうした事態に気づかず、新ツアー・キャンペーンページの公開速度が遅れても原因が分からなかったのです。結局、Search Consoleのレポートでクロールが偏っている事実を把握し、不要パラメータをnoindexやrobots.txtで制御する大規模リニューアルを行うことで解決しました。もし早めにURLパラメータ管理を徹底していれば、こうした無駄なコストや機会損失を防げたはずです。

UTMや広告トラッキングパラメータの管理

マーケティング用途として、メールや広告などのリンクにutm_sourceやutm_mediumなどを付与するのは一般的です。ただしこれらのパラメータをそのまま放置すると、Googleがそれらを別URLとしてインデックスしてしまう恐れがあります。ECサイトの場合、メルマガからの商品ページリンクがSNSなどでシェアされると、結果として?utm_source=...付きのURLにアクセスが集中し、それが検索結果に出るケースがあるのです。

canonicalで正規URLを宣言

トラッキングパラメータ付きでも本質的なコンテンツは同じページなので、<link rel="canonical" href="パラメータなしURL">を記述しておくのが定番対応です。こうしておくと、検索エンジンは評価やインデックスをパラメータなしURLに集約し、トラッキング付きURLのほうはインデックス対象外と認識します。

robots.txtでまとめてブロック

クローラビリティをとにかく確保したい場合、一切のutm付きURLをクロールさせたくないなら、Disallow: /*utm_のようにrobots.txtでブロックする方法もあります。ただし、ブロック設定をする前にそれらが既にインデックスされている場合は、一度noindexを使わないと確実には検索結果から消えてくれません。状況を確認しながら段階的に対応しましょう。

Analytics設定も含めた見直し

Google Analytics(GA4等)側でクエリパラメータをレポートから除外する設定もできます。ECサイトのレポートを見やすくし、同じページが複数のURLで集計される問題を防げます。SEOの観点だけでなく分析上もメリットが大きいため、できるだけパラメータを整理し、レポートをスッキリさせるとチーム全体の運用効率が上がります。

最新のGoogleガイドラインと今後の傾向

URLパラメータツール廃止後の自動処理

先述のとおり、Search ConsoleのURLパラメータツールが2022年に廃止された背景として、Googleの自動処理能力が高まってきたことが挙げられます。Googleは類似コンテンツの判別精度を向上させ、重複ページをアルゴリズムで統合する仕組みを強化しています。ECサイトのように重複や薄いページが多く発生しやすい分野では、これまで以上に「サイトの設計段階で不要ページを作らない」「どうしても必要な派生ページだけをきちんと正規化する」という方針が求められます。

ヘルプフルコンテンツアップデートとの関連

2022年以降、Googleは「ユーザーに役立つコンテンツを高く評価し、薄いコンテンツや重複ページは評価を下げる」という方針を強化するアップデートを実施しています。ECサイトは商品データを大量に扱うため、重複した説明文や在庫切れページの乱立、あるいはファセット検索結果の薄いコンテンツが大量発生するなど、質の低いページを量産しがちです。こうしたページの存在は全体評価にも影響し得るため、パラメータ管理で重複ページを削減し、ユーザーニーズに合ったページだけを重点的に残すことが今後ますます重要になります。

モバイルファースト・構造化データとの整合性

モバイルファーストインデックス下では、モバイル版がサイトの主軸となるため、URL構造もモバイル版と一致していることが理想です。もしモバイルURLが別ドメイン(m.example.comなど)ならば、その分パラメータ管理が複雑化する可能性があります。近年はレスポンシブデザインが推奨される傾向にあり、URLを統一しやすくなるため、結果的にパラメータ問題が緩和される利点もあります。また、商品情報に構造化データを活用するサイトが増える中で、重複URLを正規化しておかないと構造化データの評価が分散する恐れもあるため要注意です。

まとめ:ECサイトにおけるURLパラメータとクローラビリティをどう最適化するか

- 設計段階で不要パラメータを作らない工夫

絞り込みや並び替えなどの機能を実装する際、すべてをURLパラメータ化するのではなく、極力静的URLやAJAX方式で対応するなど、最初から無数の派生URLを生まない設計を意識しましょう。 - 重複ページはcanonicalやnoindexで集約・除外

- ほぼ同じ内容を返すページは正規URLにcanonicalで統合し、インデックスを一元化します。

- 検索結果ページや在庫切れページなど、ユーザーが検索からアクセスする必要のないページはnoindexで除外します。

- 内部リンク構造とrobots.txtでクローラーを誘導

- 無数に生成されるフィルタリンクはnofollowやJavaScriptによる制御を検討。

- どうしてもクロールさせたくないURLパターンはrobots.txtで一括ブロック。ただし、既にインデックス済みの場合はnoindexからのアプローチが必要です。

- サイトマップと高速表示で優先クロールを狙う

- インデックスさせたいページをXMLサイトマップに明示し、更新のたびにSearch Consoleへ送信。

- サイト速度とサーバー応答を改善し、Googlebotがより多くのページをクロールできるようにする。

- EC運営の実務に合った継続的監査

- 新商品や季節イベントなどでフィルターが増えるたびに、どのようなパラメータが生成されているか定期的にチェック。

- 重複率やインデックスされているURLリストをモニタリングし、不要ページのnoindex化やcanonical設定を適宜更新する。

- Googleの自動処理に期待しつつ、制御が必要な部分を的確にサポート

- 最新のアルゴリズムは多くの重複ページを自動判断してくれるが、万能ではない。

- ECサイトでは戦略的に、どのパラメータ付きページをSEO上重視し、どれを除外すべきか方針を固めておくのが鍵。

ECサイトは、商品数の多さやフィルタ機能の豊富さゆえにURLパラメータ問題が顕著に表れやすい領域です。クローラビリティを最適化するうえで、まずは「無数の派生ページを作らない」「どうしても生成されるページは正規化やnoindexで処理する」ことが基本になります。特に新商品や在庫・価格の変動が多いサイトでは、せっかく良い商品があってもクローラーがたどり着かず、検索順位も上がらないまま埋もれる事態は避けたいところです。

今後もGoogleのアルゴリズムは進化し続け、「パラメータ付きURLの扱いはクローラーにお任せでOK」という流れがさらに強まる可能性があります。しかし、それでもサイト側で情報設計を工夫し、不要なページを減らす努力は必要です。ヘルプフルコンテンツアップデートに代表されるように、検索エンジンは「ユーザー視点で分かりやすく整理されたサイト」を高く評価します。膨大なパラメータ付きURLが乱立するサイトより、必要最小限のURLでコンテンツを提供するサイトのほうが、巡回効率も良く評価も集まりやすいのです。

ECサイト運営者としては、ビジネス上「どうしても導入したい機能」で生じるパラメータは受け入れつつ、そこから派生する重複ページをnoindexやcanonicalで適切に統合する、またはユーザーが実際に必要とする主要な絞り込み以外はURL化しないといった対応が欠かせません。最終的には、サイト全体で「どのURLがユーザーにとって本当に価値があり、検索エンジンから見ても重複でないか」を精査することが大切です。

ぜひ自社サイトのURLパラメータを洗い出し、「何が必要で、何が不要か」を明確にしてみてください。パラメータをスリム化したり正規化するだけで、思いのほか早くクローラーが巡回してくれるようになるかもしれません。日々の商品アップロードや広告施策に追われがちなECサイトこそ、この地道なテクニカルSEO対策が大きな差を生み出します。クローラビリティが改善すれば、インデックスが迅速化し、新商品の露出が向上し、ひいては売上増にもつながるはずです。ぜひ本記事を参考に、URLパラメータ管理とクローラビリティ最適化を進めてみてください。